帮助中心

如果没有找到你需要的问题,随时联系我们

服务器搭建的DeepSeek如何与Chatbox进行对接?2025/4/27 11:35:24

|

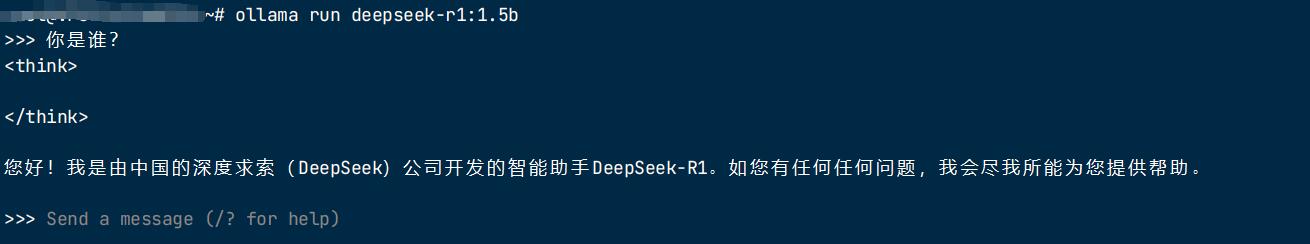

Linux服务器远程搭建的DeepSeek如何与Chatbox进行对接? 如果您在服务器通过Linux部署好了DeepSeek大模型,默认是只能在字符界面进行对话的。 如下图:

为了获得更好的交互体验,可以安装 Chatbox 作为 GUI 界面。 下载地址:https://chatboxai.app/zh#download

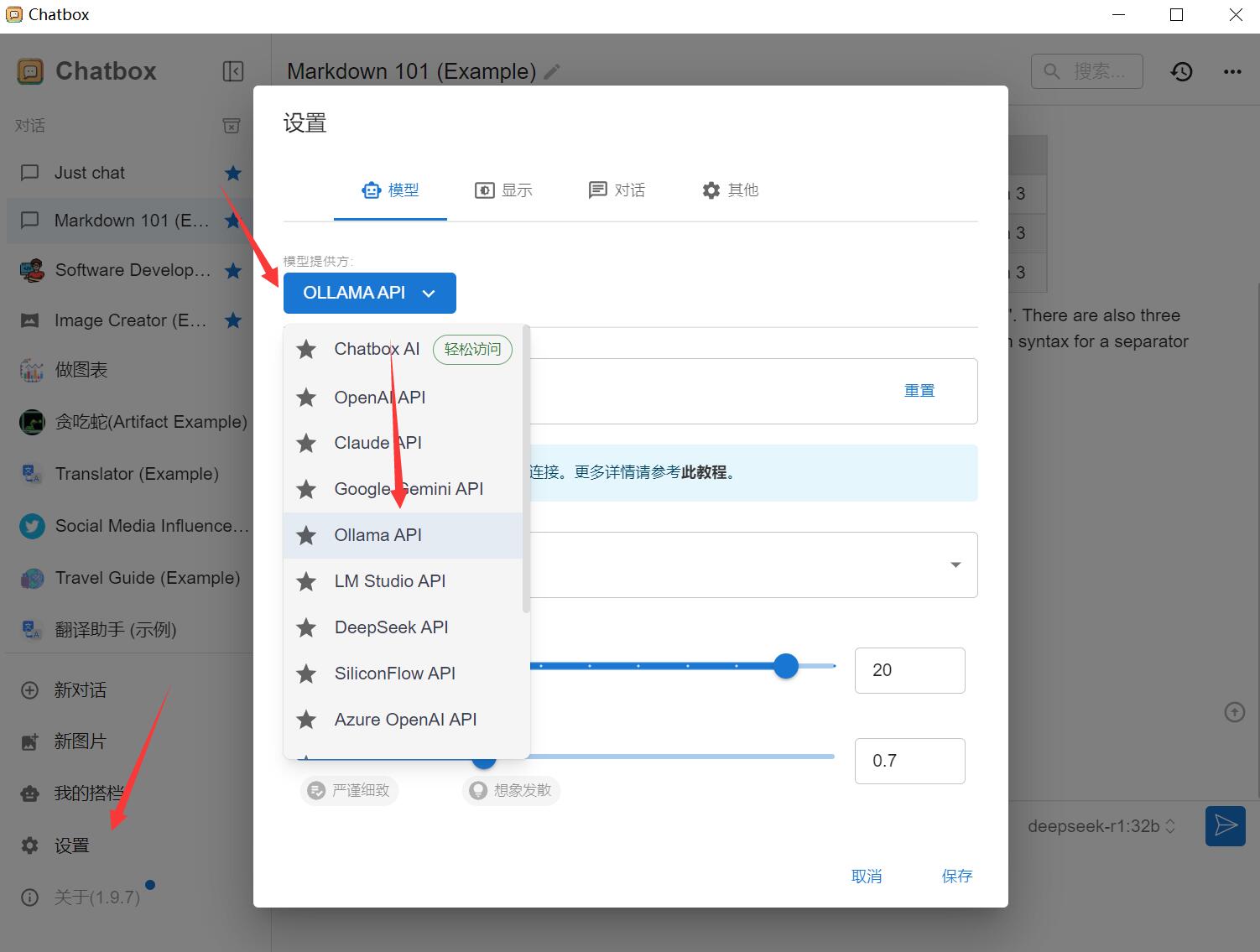

下载后直接双击后即可。 安装完成后,进行以下配置:

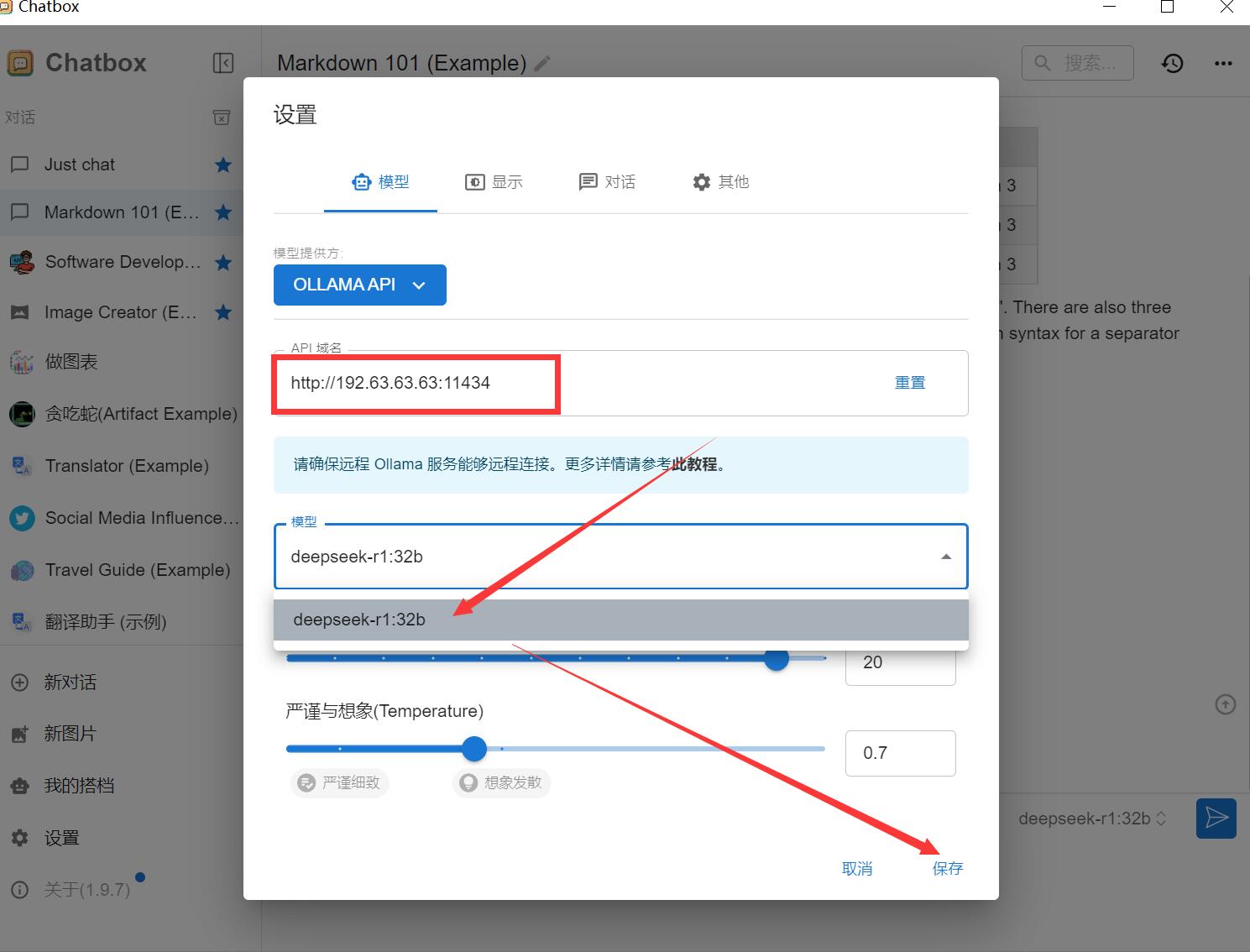

在“配置 API 模型”选项中选择 Ollama API。 假如您的服务器IP是:192.63.63.63 那么这里设置 API 主机为:http://192.63.63.63:11434 选择 DeepSeek R1 作为默认模型。 保存设置。

请注意:默认安装好的 Ollama 服务是不对外开放的,如何配置远程 Ollama 服务?默认情况下,Ollama 服务仅在本地运行,不对外提供服务。要使 Ollama 服务能够对外提供服务,你需要设置以下两个环境变量: 如果 Ollama 作为 systemd 服务运行,应使用 systemctl 设置环境变量:

此时打开Chatbox ,选择对接好的DeepSeek ,即可正常对话。 |

公告

Copyright © 2026 All Rights Reserved

湘ICP备16022455号

湘公网安备43310002000112号

已安全稳定运营:

友情连接:idc公司大全 | 备案号查询 |

湘公网安备43310002000112号

已安全稳定运营:

友情连接:idc公司大全 | 备案号查询 | ![]()

管理控制台

管理控制台